ВТБ 24, «Газпромнефть», «Магнит» и «Мегафон» поделятся секретами работы с данными

О том, как из списка прорывных технологий Gartner исчезли большие данные, почему компании не спешат делиться секретами их монетизации и когда будут обнародованы новые кейсы, в преддверии Teradata Форума 2015 рассказал Андрей Суворкин, руководитель направления Big Data, Teradata Россия.

CNews: В этом году из знаменитого Цикла зрелости развивающихся технологий Gartner 2015 исчезли большие данные. Как вы прокомментируете это решение аналитиков?

Андрей Суворкин: На этой кривой Gartner отмечает технологии, которые вызывают наибольший интерес средств массовой информации, венчурных инвесторов и так далее. Некоторые из них в конце концов превращаются в серьезные решения, становятся частью индустрии, а некоторые умирают просто потому, что так и не смогли найти себе применения. Большие данные исчезли не по причине своей невостребованности. Просто сегодня эти технологии уже заняли на рынке настолько весомую долю, что называть их развивающимися стало некорректно.

CNews: Согласно циклу 2014 года технологии больших данных должны были достичь плато продуктивности в ближайшие 5-10 лет. Можно ли сегодня утверждать, что они совершили большой рывок в своем развитии?

Андрей Суворкин: Да, причиной исчезновения больших данных из кривой Gartner стало именно то, что эти технологии миновали нишу разочарования и сразу перешли в плато продуктивности, то есть стали просто еще одной технологией, которую все используют, но которая тем не менее продолжает очень активно развиваться.

CNews: Какие технологии, по вашему мнению, можно отнести к стеку больших данных?

Андрей Суворкин: В большинстве своем, технологии больших данных сегодня ассоциируются с экосистемой Hadoop. За последние полгода здесь появилось много новых продуктов – это проекты под лицензией Apache, дистрибутивы от Cloudera, Hortonworks и MapR, а также разработки независимых компаний. Очень активно развиваются технологии in-memory вычислений – анализа и обработки данных в оперативной памяти, позволяющих значительно ускорить этот процесс. В первую очередь здесь стоит упомянуть Spark – технологию, которая сейчас привлекает, пожалуй, наибольшее внимание как со стороны вендоров – разработчиков продуктов, так и пользователей.

Еще одно перспективное направление – развитие новых технологий хранения данных. В экосистеме Hadoop есть приложения «на все случаи жизни», решения для всестороннего анализа данных.

CNews: Как соотносятся технологии больших данных с действующими «участниками» гартнеровского цикла: интернетом вещей и машинным обучением?

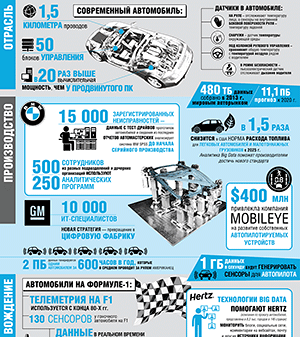

Андрей Суворкин: Большие данные – это набор технологий для обработки десятков, сотен терабайт и даже петабайт данных. За интернетом вещей стоят десятки технологий – это и различные сенсоры, и механизмы их взаимодействия между собой, и специализированные отраслевые решения. Безусловно, интернет вещей является поставщиком информации для любых технологий анализа, в том числе и для больших данных.

Андрей Суворкин: Идея обработки больших данных состоит в том,

что гипотезы, кейсы нужно проверять быстро и достаточно дешево

Интернет вещей – очень обширное понятие. Например, когда телеком-оператор собирает данные со своей сетевой инфраструктуры о том, насколько загружена базовая станция, сколько одновременно пользователей в ней находится и т.д., это вполне можно считать частью парадигмы интернета вещей. Просто сегодня такие решения уже настолько привычны, что никто их так не называет.

В целом, под интернетом вещей понимается взаимодействие различных устройств между собой и анализ данных об этом взаимодействии. Этих данных очень много, они слабо структурированы, и это открывает широкие возможности для применения технологий больших данных.

Что касается алгоритмов машинного обучения, то они существуют уже достаточно продолжительное время. Но именно появление технологий обработки больших данных стало существенным стимулом для их развития и позволило добиться реальных, значимых результатов от их применения. Многие продукты, реализующие механизмы машинного обучения, так или иначе основываются на использовании технологий больших данных. И в данном случае, между машинным обучением и большими данными, наверное, связь гораздо более тесная.

CNews: Расскажите о новом решении Teradata для интернета вещей.

Андрей Суворкин: Наш новый продукт называется Teradata Listener. Он позволяет загружать данные из множества источников в различные системы в режиме реального времени. Источников может быть очень много как по типам, так и по количеству. Данные интеллектуально маршрутизируются и гарантированно доставляются с задержкой не более десятка миллисекунд в аналитические системы, где впоследствии будут обрабатываться. Под аналитическими системами мы понимаем, прежде всего, Teradata Database, Teradata Aster и Hadoop. При этом Teradata Listener полностью отвечает за балансировку нагрузки, восстановление в случае сбоев, обеспечивает масштабирование без прерывания сервиса.

Другого такого продукта, способного работать со всеми тремя типами систем и маршрутизировать данные подобным образом, я на рынке пока не видел. И в этом его уникальность. Все необходимые действия по управлению и мониторингу можно производить через удобный веб-интерфейс, а не долго и сложно конфигурировать через командную строку Linux.

CNews: С какими проблемами сталкиваются российские компании, запускающие проекты в области больших данных, интернета вещей? И каковы ваши рекомендации по их преодолению?

Андрей Суворкин: Идея обработки больших данных состоит в том, что гипотезы, кейсы нужно проверять быстро и достаточно дешево. Это парадигма, абсолютно противоположная тому, к чему компании привыкли сегодня, и им бывает очень непросто на нее перестроиться. И, конечно, компаниям часто сложно оценить перспективы от проекта больших данных – они просто не знают, какова ценность того, что у них хранится и что они могут собрать.

Для того чтобы преодолеть эти сложности, надо успешно решить одну-две задачи. Тогда возможности и преимущества больших данных станут очевидны.

CNews: Многие говорят, что самым сложным этапом является интеграция больших данных. Как вам кажется, почему?

Андрей Суворкин: Я бы сказал, что интеграция – не самый сложный, а самый затратный процесс. Нужно предварительно договориться со всеми владельцами данных, убедить их в необходимости интеграции. Иногда возникают проблемы с поиском специалистов, способных создать необходимую архитектуру. Кстати, именно в таком случае можно успешно использовать Teradata Listener – ведь это готовое интеграционное решение, требующее от клиента минимума усилий как с точки зрения настройки техники, так и в области номенклатурной работы.

CNews: Насколько остро стоит вопрос монетизации больших данных? Как он решается в России?

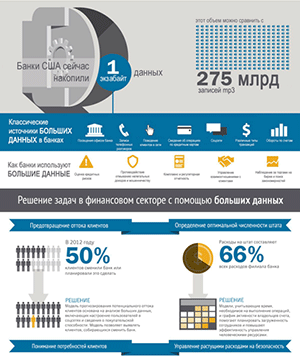

Андрей Суворкин: Число кейсов по монетизации больших данных растет во всем мире. Сегодня о том, как это сделать, хорошо знают и телеком-операторы, и ритейлеры и финансовые организации. Для первых это анализ сети загрузки, планирование сети, создание карт нагрузки и путей перемещения абонентов. Для вторых – анализ потребительских корзин и создание персонализированных предложений. Финансовые организации используют технологии больших данных для оценки рисков, выявления мошенничества, предотвращения оттока клиентов. Эти кейсы понятны на уровне здравого смысла и успешно внедряются. Однако многие бизнес-заказчики до сих пор считают, что большие данные – это игрушка, и без нее легко можно обойтись. Ну что же, время покажет, у кого потом окажется конкурентное преимущество.

CNews: Каково значение визуализации данных?

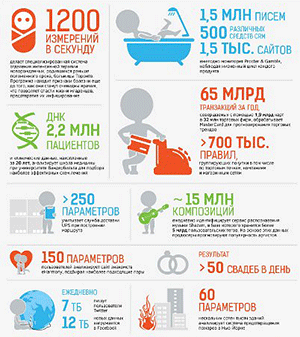

Андрей Суворкин: Правильно сделанная визуализация позволяет увидеть результаты, которые не столь очевидны при отображении в стандартном виде. Поэтому она может быть критически важной для успешности проекта как на промежуточном, так и на заключительном этапе. Кроме того, визуализация позволяет продвигать идею больших данных не только внутри компании, но и за ее пределами.

Мы предлагаем несколько десятков встроенных функций визуализации в рамках нашего продукта Aster Discovery Platform, а также возможность дополнительной разработки собственных вариантов. Таким образом, наши заказчики могут реализовать и представить практически все возможные аналитические кейсы почти «из коробки».

CNews: Насколько активно эти технологии применяются в России?

Андрей Суворкин: Проблема в том, что у нас очень мало публичных кейсов. Все, кто смог что-то сделать, очень закрыты.

CNews: С чем это связано? Нежелание делиться экспертизой?

Андрей Суворкин: Думаю, да. Люди нашли свое ноу-хау, прошли долгий тернистый путь, получили, условно говоря, копеечку, а, может, и миллион копеечек. Отчасти это особенность менталитета многих российских компаний.

На нашем форуме в ноябре будут впервые представлены некоторые кейсы о результатах проектов в области больших данных и построения аналитической экосистемы. Среди докладчиков - крупнейшие банки, представители нефтегазового и транспортного сектора, известные розничные сети и телеком-операторы.

Мы покажем потрясающие картины визуализации данных, Стивен Бробст расскажет об искусстве аналитики. Прозвучит и немало западных кейсов, успех которых вполне можно повторить и в России.