Это не большие данные, если…

Большие данные – что это, технологии, маркетинг или философия? Однозначное определение этого понятия до сих пор формулируется экспертным сообществом. CNews предлагает для большей терминологической ясности пойти от обратного и отсечь то, что к большим данным точно не относится.

Определить феномен больших данных оказалось непросто, так как понятие активно используется и как маркетинговый, и как технический термин, и даже просто как модная формулировка, без какого-либо конкретного наполнения, считает Александр Горный, ИТ-директор Mail.Ru Group. «На рынке много компаний, которые предлагают решения на основе больших данных, зная про большие данные только то, что это модно и за это многие готовы платить», – сетует эксперт.

Однако если все же озадачиться сутью термина, то имеет смысл ограничить его снаружи. Итак, это не большие данные, если…

…если данные структурированы

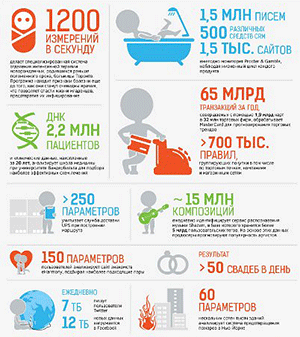

Неструктурированность многие считают ключевым понятием в определении больших данных от компании Gartner. По этой версии большие данные требуют соблюдения трех условий: большой объем, высокая скорость обработки и разнообразие данных. «Если данные можно легко разбить по строкам и столбцам таблицы, то есть они хорошо структурированы, тогда, как правило, несмотря на большой объем и высокую скорость накопления для их анализа подходят уже имеющиеся методы. В противоположность – при анализе архива постов Twitter за несколько лет скорость накопления данных будет равняться нулю, но объемы информации и ее неструктурированность не позволят произвести должный анализ стандартными средствами», – поясняет Камиль Исаев, вице-президент ЕМС Россия и СНГ, генеральный директор Центра разработок и исследований в Сколково.

Первоочередная задача проектов больших данных – анализировать данные, структура которых заранее неизвестна и более того может меняться. Поэтому определять структуру этих данных приходится непосредственно в процессе обработки. «В таких проектах объемы данных, с которыми мы работаем, настолько велики, что затраты на предварительное приведение этих данных к структуре, поддерживаемой реляционными СУБД, с целью последующей обработки, существенно превышают затраты на обработку этих данных в их первоначальном неструктурированном виде. Важность тех или иных затрат определяются конкретной задачей – иногда нужно сделать быстро, иногда дешево», – считает Сергей Заблодский, директор по развитию бизнеса дивизиона бизнес-решений компании IBS.

В ряде проектов данные могут накапливаться так быстро, что оказывается важнее обрабатывать свежие данные, содержащие актуальные зависимости и тренды. В таких случаях тратиться на структурирование разнородных данных тем более бессмысленно, так как они нужны по сути «на один раз», к следующему разу будут уже новые данные, считают эксперты.

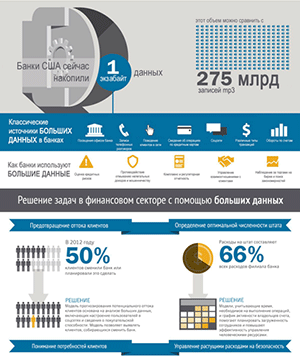

Этот пункт «если», как впрочем и остальные, нельзя считать самодостаточным и важно рассматривать во взаимосвязи с другими. Все же есть настоящие проекты больших данных, анализирующие структурированную информацию. Например, телеком-компании генерируют огромные объемы информации, которую очень легко структурировать. «Сотовые операторы аккумулируют детализации звонков (CDR), которые можно быстро разложить, сведения о финансовых транзакциях абонентов и другую структурированную информацию, которую можно использовать для ответов на очень сложные вопросы. Например, как изменение уровня обслуживания на конкретном коммутаторе повлияет на самых прибыльных заказчиков, испытают ли они проблемы, и с какой вероятностью часть из них откажется от услуг компании в этом регионе. Задача классическая, так как все надо в хранилище сложить, но уровень анализа здесь такой, что без технологий больших данных не обойтись. Иначе запрос будет исполняться несколько недель», – рассказывает Сергей Лихарев, руководитель продаж IBM Big Data Solutions в странах Центральной и Восточной Европы.

… если ответ приходит завтра

Помимо нереляционных СУБД в классическом проекте больших данных, как правило, задействуются новые методы высокопроизводительного анализа данных – такие, как вычисления в оперативной памяти, обеспечивающие обработку информации в режиме реального времени.

…если мы знаем, что ищем

Задача аналитика больших данных состоит не в том, чтобы найти правильный ответ, а в том, чтобы найти правильный вопрос, – считает Стивен Бробст (Stephen Brobst), директор по технологиям корпорации Teradata. Одной из основных характеристик проектов больших данных является отсутствие четкого понимания, что в данных надо найти. «Мы ищем зависимости, но заранее не знаем что найдем», – соглашается Сергей Заблодский.

Размер не имеет значения

Как это ни парадоксально, но объем данных, на который казалось бы намекает сам термин – большие данные – не имеет определяющего значения. «К большим данным относятся специфические технологии повышения эффективности вычислений. Их можно применять и при наличии всего нескольких гигабайт данных. В то же время компания может располагать терабайтами информации, но не применять технологии больших данных», – подчеркивает Андрей Свирщевский, руководитель направлений аналитики и гарантирования доходов компании SAS Россия/СНГ.

Эксперты настаивают, что необходимо разделять проекты по созданию масштабных высоконагруженных систем и проекты по большим данным, поскольку существует большое количество задач, для решения которых системы, перерабатывающие петабайты данных, создавались и будут создаваться на основе традиционных DWH-технологий, т.е. без использования инструментов больших данных. «Часто работу с большими объемами данных (десятки терабайт, петабайты) называют «Биг дата», хотя это просто базы данных с повышенной нагрузкой (highload DB). Например, систему определения предпочтений пользователей (Next Best Offer) для крупных магазинов ошибочно считают проектами больших данных, хотя в них используются алгоритмы индексации информации, нереляционные хранилища информации и прочее. По сути с такой информацией работали и раньше, входные данные здесь структурируются, быстрый доступ зачастую не требуется. В итоге остается лишь растущий объем информации», – комментирует Сергей Кузнецов, директор по технологиям дивизиона бизнес-решений IBS.

Резюмируя, можно сказать, что большие данные – производное понятие от объема информации и того, что с нею делают. Под проектами больших данных прежде всего понимается глубинная аналитика в режиме реального времени.

Проекты больших данных

Практически сразу, как только термин «большие данные» набрал популярность на российском рынке, стали появляться утверждения о том, что кто-то, где-то уже давно делает и продолжает делать такие проекты. Однако, как правило, речь шла об очень больших хранилищах данных, возможно, создаваемых с использованием специализированных программно-аппаратных комплексов (DWH Appliance). «Традиционный и BigData-подход больших данных не являются антагонистами. В результате проекта больших данных может быть обнаружен интересный паттерн в данных, для регулярного извлечения пользы из которого требуется создать решение на базе традиционных технологий хранения. Такое взаимодействие традиционных и BigData-подходов хорошо раскрывается концепцией лямбда-архитектуры», – добавляет Сергей Кузнецов. CNews выделил проекты, которые наиболее часто относят к большим данным и попросил экспертов прокомментировать их.

| Пример проекта | Это большие данные? | Комментарий |

| Анализ большого объема неструктурированной информации из различных источников в режиме реального времени | V да | Классический пример |

| Анализ перемещения покупателей в магазинах по сигналам WiFi | V да | Этот тип проектов будет относиться к большим данным, если необходимо производить анализ в реальном времени и при возникновении определенных событий (например, покупатель подошел к стенду) предпринимать определенные действия или же на основе анализа данных за большой период делать решения об изменении расстановки товаров, соотносить траектории с типами клиентов и т.д. |

| Быстрое формирование финансовой отчетности высокопроизводительными средствами больших данных | ? мнения разделились | В классическом понимании нет, хотя технологии больших данных могут быть использованы, если объемы и сложность расчетов и преобразований не позволяют традиционным технологиям удовлетворять требованиям по быстродействию |

| Анализ большой по объемам, но структурированной информации из внутренних источников | ? мнения разделились | В классическом понимании нет, хотя в этом случает использование технологий больших данных оправдано, чтобы уменьшить стоимость хранения и обработки больших объемов информации и сократить время анализа или провести анализ по очень сложным алгоритмам (телеком) |

| Потоковая обработка однородных структурированных данных | ? мнения разделились | Подобные задачи традиционно решались в производственных и биржевых системах до появления технологий больших данных. Однако существует целый ряд новых задач, когда нужно «на лету» объединить разнородную информацию и обеспечить принятие решений в реальном времени. Например, сверить биометрические данные в потоках людей с базами злоумышленников, данными о пересечении границ, авиабилетами и пр. |

| Обработка неструктурированных данных (текстовая и видеоаналитика) | ? мнения разделились | Зачастую подобные решения относят к большим данным, хотя алгоритмы интеллектуальной обработки информации развиваются в течение десятков лет. Машинное обучение успешно применялось до появления термина «большие данные». В наши дни можно говорить об отнесении подобных решений к категории больших данных, если они реализуются на больших объемах информации в режиме времени близком к реальному |

| Обработка небольших объемов неструктурированной информации | X нет | Например, подключение к социальной сети с целью анализа информации о каком-то заранее известном пользователе |

| Терабайт данных, обрабатываемый на одном большом сервере | X нет | Размер не имеет значения – см. выше |

Источник: СNews Analytics, 2014

Эксперты склоняются к тому, что каждый проект, в котором заявляется анализ больших массивов данных, надо рассматривать индивидуально. «Проект может начинаться с анализа совсем небольшого объема данных, и тем не менее в перспективе дорасти до этого определения. Допустим, делается анализ ДНК на предмет наличия наследственных заболеваний. Если он делается у одного или нескольких человек, то формально – это небольшой объем данных. Если исследование будет вестись по отношении к определенной популяции, то мы столкнемся с куда более сложной задачей, полностью попадающей под определение больших данных», – считает Камиль Исаев.

Александра Кирьянова