Как развернуть «озеро данных»: 5 советов

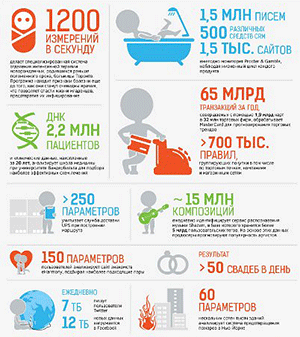

«Озеро данных» (data lake) – один из элементов экосистемы big data, где централизованно агрегируются большие объемы данных из множества источников. Как и в случае с самой big data, ключевой вопрос в связи с «озерами» не в том, маркетинговый это термин или технологический, а в том – насколько такие «озера» действительно необходимы предприятиям и как их можно монетизировать.

Развитие концепции big data сопровождается не только дискуссиями по поводу адекватного определения самого понятия, но и появлением дополнительных новых терминов. Одно из них – «озеро данных» (data lake), под которым понимается репозитарий, хранящий большие объемы данных в сыром, необработанном виде – «до востребования».

В Gartner комментируют, что «озера данных» позволяют анализировать различные несопоставимые данные в их оригинальном формате. Это не требует больших затрат на хранение и обработку, а данные из «озера» могут быть доступны любым пользователям в компании.

Данные поступают и хранятся в «озере», потому что заранее неизвестно, на какие вопросы они отвечают – и какую ценность могут дать. Другими словами, «озеро» не может заменить собой традиционное хранилище данных. Однако оно должно обеспечить организации новые аналитические возможности и инсайты, способствуя одновременно оптимизации ее расходов на обработку и хранение данных.

Эксперты Teradata отмечают частый вопрос компаний, много лет потративших на построение хранилища, о том, нужно ли им в таком случае еще и «озеро»? По их словам, его можно использовать для более дешевого хранения и функций ETL, и в принципе вместе эти технологии дают больший эффект. Важное отличие «озера» – то, что оно может масштабироваться до экстремальных объемов данных при по-прежнему низких издержках. А также может обеспечивать мгновенный доступ к любым данным для всех пользователей. Хотя без соответствующего опыта этот доступ вряд ли будет действительно полезен. В отличие от традиционных хранилищ, где данные структурированы, «озера» позволяют дешево хранить любые их типы, поступающие из социальных сетей, с различных устройств, в том числе и в аудио и видео форматах.

В то же время аналитики отмечают, что накапливание «озер» подразумевает определенные риски. Например, в «озеро» помещаются любые данные – практически бесконтрольно. Невозможно определить их качество. Нет задачи обеспечить их безопасность и контролировать доступ к ним. Эффективно работать с данными из «озера» может в первую очередь аналитик, но в то же время доступны они всем бизнес-пользователям. Наконец, главный риск – что со временем эти «озера» рискуют превратиться в «болота». Откуда уже невозможно будет извлечь никакую дополнительную ценность.

Ключевой вопрос в связи с «озерами» остается в том, насколько такие «озера» необходимы и полезны для предприятий. Стивен Бробст, СТО Teradata, комментирует, что «озера» не нужны сами по себе – бизнес достаточно долго существовал без них. «Однако поступающие данные нужно куда-то складывать, – отмечает он. – Не в хранилища (иначе это слишком дорого), а в более дешевое место. В философии big data ничего нельзя выбрасывать, особенно если цена хранения может быть достаточно низкой. Если выбросить данные сразу – об их ценности уже никогда не узнаешь. Правда, определить потенциальную ценность таких данных сложно, а если бы она сразу просматривалась, данные уходили бы, скорее всего, в хранилище, а не попадали бы в «озеро». Чтобы оно не превратилось в «болото», определенный порядок в таких данных все же надо наводить».

В принципе организации не обязательно создавать и держать такое «озеро» у себя, считают в Teradata. Сегодня уже существует практика их аутсорсинга, и компания предлагает соответствующие инструменты для работы с ними. «Озеро» может храниться в облаке – как у заказчика, так и на ресурсах Teradata.

Комментируя же маркетинговый аспект термина, Стивен Бробст отмечает, что это привлекательное название реального инструмента. По его словам, такая привлекательность недолговечна. Так, он считает, что и понятие больших данных в ближайшие годы исчезнет – останутся просто «данные». Да и сейчас важнее не то, что они большие, а скорее то, что они умные (smart data).

Стивен Бробст: 5 заповедей «озера данных»

СTO Teradata приводит 5 простых советов по развертыванию «озер данных», которые позволят компаниям эффективнее использовать накапливаемые данные.

Не засоряйте «озеро данных». При том, что данные могут храниться в «озере» без структуры, все же имеет смысл сразу организовывать пространство для хранения и размещать данные по категориям. Тогда любой пользователь сможет быстрее найти и применить необходимые ему данные. А «озеро» не превратится в «болото».

Обеспечьте безопасность данных в «озере». Защита персональных данных и конфиденциальной информации сразу должна стать первостепенной задачей. Данные из «озера» не должны «утекать» или создавать проблемы с регуляторами.

Снабдите аналитиков необходимыми инструментами для исследования, профилирования и получения ответов на свои запросы из «озера данных». С данными сразу должны иметь возможность работы не только (и не столько) разработчики, но и бизнес-специалисты, которым эти инструменты будут полезны.

Поддерживайте доверие к данным. Данным из «озера» будут доверять, и для поддержки этого доверия нужно, как минимум, фиксировать их происхождение. Особое внимание следует уделить качеству метаданных.

Свяжите «озеро данных» с аналитической экосистемой предприятия. В «озере» должны накапливаться структурированные, полуструктурированные и неструктурированные данные, а само по себе «озеро» будет представлять симбиоз технологий Hadoop, реляционных баз данных и NoSQL, а также облачных сервисов. При этом «аппаратная» составляющая должна быть выбрана по принципу минимальной стоимости хранения информации. В идеале все данные должны храниться «вечно», но с минимальными издержками.

Подробнее об озерах данных и лучших практиках их построения – на Teradata CTO Roadshow 2015.