Оценка масштабов эпидемии гриппа от Big Data превышает официальную статистику

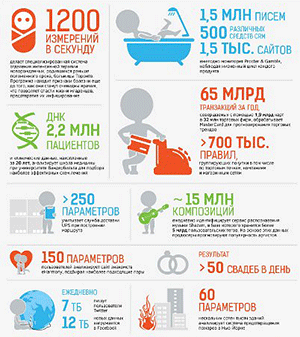

Проект Google Flu Trends (GFT), использовавший «большие данные» поисковой системы для мониторинга эпидемии гриппа, переоценивал число заболевших гриппом более чем на 50%. К такому выводу пришли сотрудники Северо-Восточного университета (Northeastern University) в Массачусетсе, которые проанализировали деятельность проекта с 2011 по 2013 гг. Ученые сравнили прогнозы GFT со статистическими данными Центра по контролю и профилактике заболеваний (CDC). Результаты исследования опубликованы в журнале Science.

Проект Google Flu Trends отслеживает поисковые запросы, связанные с гриппом, и на основе этих данных определяет степень распространения эпидемии гриппа и ее эпицентры. Исследователи Северо-Восточного университета выяснили, что в эпидемиях 2011–2012 и 2012–2013 гг. Google прогадал в расчетах более чем на 50%. С августа 2011 г. по сентябрь 2013 г. GFT завысил степень распространения гриппа в 100 неделях из 108. К примеру, зимой 2013 г., по прогнозам GFT, гриппом должны были заболеть 11% американцев. Данные Центра по контролю и профилактике заболеваний показывают, что больных оказалось всего 6%.

Авторы исследования поясняют, что Google стал жертвой «технологического высокомерия». Наличие крупных массивов данных не гарантирует то, что они будут точными и эффективными. Ученые считают, что GFT собирал большое количество данных, которые не имеют отношения к реальным случаям заболевания. В то же время проект не учитывал неожиданные происшествия (например, внесезонную вспышку эпидемии в 2009 г.).

Ученые Северо-Восточного университета считают, что «большие данные» могут эффективно работать лишь в сочетании с тем, что в рамках этого исследования называют «маленькими данными». Под «маленькими данными» ученые подразумевают традиционные способы сбора информации, с помощью которых компании могут проверять и корректировать выводы аналитики Big Data. Так, в случае с GFT Google мог значительно улучшить результат своих прогнозов, если бы обратился к данным Центра по контролю и профилактике заболеваний за предыдущие годы.

Технологии Big Data – просто инструменты, которые дают новые технические или экономические возможности для решения задач, считает Андрей Пивоваров, руководитель группы перспективных технологий предпроектного консалтинга Oracle СНГ. «В данном случае Big Data как раз позволили провести масштабный эксперимент по анализу огромного объема данных за длительный промежуток времени с целью проверки красивой гипотезы. Возможно, гипотеза оказалась не совсем верна. Но именно возможность проверять гипотезы двигает науку вперед», — подчеркивает эксперт.

Не стоит рассматривать этот пример, как провал, ведь системы, аналогичные GFT, всегда являются самообучаемыми, и ошибки, которые они допускают, – это цена за их развитие, уверена Татьяна Лякишева, директор направления аналитических решений дивизиона данных IBS. «То, что на рынке появилась новая технология, не означает, что все сразу научились извлекать из нее экономический эффект. Лучше приготовиться к тому, что в ближайшее время лишь небольшое количество таких проектов будет переходить в режим формирования постоянного корректного результата», — заключает эксперт.

В компании Google сообщили, что последний раз сервис обновлялся в октябре прошлого года в преддверии эпидемии гриппа 2013–2014 гг. Работа над совершенствованием сервиса Flu Trends ведется постоянно.